Im Gespräch mit den beiden Sicherheitsforscher:innen Luise Frerichs und Fabian Bräunlein reden wir unter anderem über ihre Arbeit beim Forschungsinstitut SRLabs sowie ihre Meinung zu Smart Toys und Künstlicher Intelligenz. Außerdem geben die beiden wertvolle Tipps zur sicheren Nutzung von Smart Speakern. Das Interview in voller Länge gibt es hier.

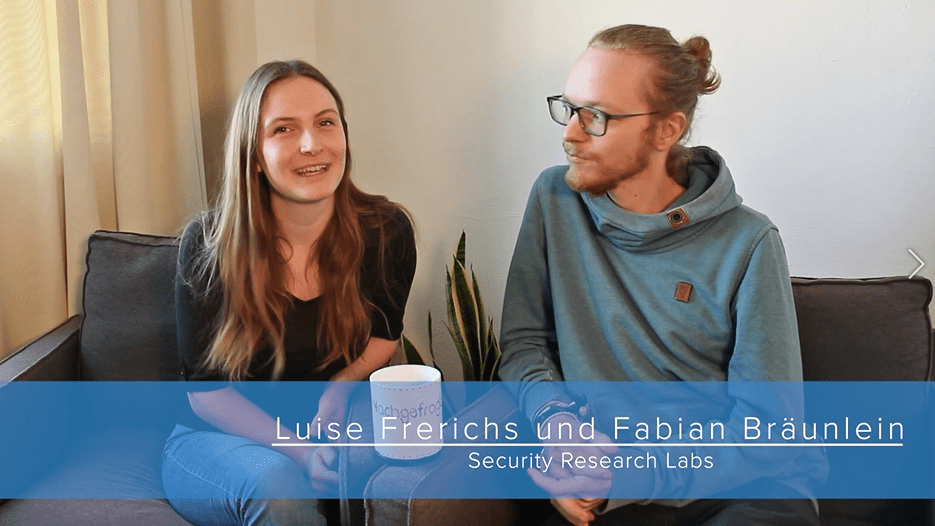

– mit Luise Frerichs und Fabian Bräunlein, Security Research Labs

Intro Media Smart e. V.: Wir sind heute in Berlin und treffen gleich auf Luise Frerichs und Fabian Bräunlein von SRLabs. Die beiden sind Profis in Sachen digitale Sicherheit und haben mit ihrem Projekt „Smart Spies“ Smart Speaker wie Alexa und Co. genauer unter die Lupe genommen und einige Sicherheitslücken aufgedeckt. Und dazu werden wir den beiden gleich ein paar Fragen stellen.

Vorstellung Luise Frerichs: Ich bin Luise Frerichs. Ich bin hier Werkstudentin bei SRLabs und habe die letzten Monate an den Smart Speakern gearbeitet.

Vorstellung Fabian Bräunlein: Ich bin Fabian Bräunlein. Ich arbeite seit fünf Jahren hier als IT Security Consultant und Forscher. Genau, und ich hab das Projekt betreut.

Media Smart e. V.: Eines der Projekte oder das, was ihr gemacht habt, war eben „Smart Spies“. Und wie seid ihr darauf gekommen, was war das Forschungsinteresse und was waren die Ergebnisse?

Luise: Das Forschungsinteresse lag vor allem daran, dass ich mir gedacht hatte, dass gerade diese Smart Speaker eben, dadurch dass hauptsächlich die Kommunikation über das Mikrofon funktioniert und man außerdem auch nach Apps Third-Party schreiben kann, also quasi als Drittanbieter, als Privatperson zum Beispiel, für diese Geräte Apps schreiben kann, die dann jeder benutzt. Dass ich da gucken wollte, was kann man daraus quasi machen, und dann eben in Zusammenarbeit mit SRLabs da ein bisschen rumprobiert habe. Und die Ergebnisse haben sich dann eben auch nach auf Google Home ausweiten lassen. Also da haben wir jetzt zwei Attacken für Alexa und Google Home geschrieben, wobei wir bei der einen Attacke nach persönlichen Informationen wie Passwörtern fragen können und bei der anderen Attacke können wir, nachdem die App eigentlich geschlossen sein sollte, das Mikrofon noch weiter offen lassen und noch weiter ein bisschen mithören.

Media Smart e. V.: Und das habt ihr jetzt ja schon vor ein paar Monaten herausgefunden und ihr habt das auch gemeldet, richtig? Und was ist seitdem passiert?

Fabian: Also wir haben Feedback bekommen, die Lücken wurden praktisch angenommen und uns wurde gesagt, dass daran gearbeitet wird. Wir haben dann nach mehreren Monaten uns entschlossen praktisch damit öffentliche zu gehen, weil eben nach mehreren Monaten noch nichts passiert ist, was wir gesehen haben an Reaktion. Zu dem Zeitpunkt ist dann ein bisschen mehr passiert. Die Pressesprecher haben eben auch gesagt, dass daran gearbeitet wird und dass es in Zukunft nicht mehr möglich sein soll. Wir haben jetzt herausgefunden, wir haben noch mal einen neuen Test gemacht, wo wir noch mal versucht haben, alle vier Angriffe praktisch online zu stellen und approven zu lassen. Und es hat wieder funktioniert. Also wir werden da auch noch mal ein Update hinterherschieben. Es haben sich vielleicht ganz ganz Kleinigkeiten geändert, aber im Grunde nicht so wirklich.

Media Smart e. V.: Das heißt, ihr bleibt dran.

Fabian: Genau.

Media Smart e. V.: Welche Chancen und Risiken seht ihr bei Smart Speakern, Künstlichen Intelligenzen?

Luise: Also die Chancen sind natürlich, dass es eine Hilfe im Alltag darstellen kann, es ist sehr leicht zu benutzen. Es ist darauf ausgerichtet zu wissen, was du gerade willst, was du gerade brauchst. Aber da liegt natürlich dann auch das Risiko, weil es dafür viele Daten von dir braucht und das macht es ein sehr interessantes Ziel für Angriffe.

Media Smart e. V.: Wie kann man denn, jetzt haben wir eigentlich vorhin schon drüber geredet, aber trotzdem noch mal, Alexa besser schützen?

Fabian: Die Frage ist ja, ob du Alexa schützen willst oder ob du dich schützen willst vor Alexa. Um dich zu schützen vor Alexa, es hilft halt so ein bisschen zu verstehen, wie Alexa funktioniert, also dass es praktisch diese Third-Party-Skills gibt, und dass die von jedem im Grunde entwickelt werden können. Das ist eben nicht von Amazon, nur weil man mit Amazon spricht. Und zum anderen, zum Beispiel so einen Tipp, den wir geben, ist möglichst drauf zu achten, wann die LED auf dem Smart Speaker an ist. Weil das ist praktisch ein guter Hinweis, wann das Mikrofon zuhört, und wenn die LED an ist, obwohl man es nicht vermutet, dann ist schon mal so ein bisschen was wahrscheinlich fishy.

Media Smart e. V.: Das ist ja schon mal ein guter Tipp. Wie würdet ihr Smart Speaker einem Kind erklären?

Luise: Also ein Smart Speaker an sich ist ja erst mal ein Lautsprecher zusammen mit einem Mikrofon und das kann man dann alles zusammen mit dem Internet verbinden. Und das ist dafür ausgerichtet, um im Alltag zu helfen, zu unterstützen, indem es lernst zu verstehen, was ein Mensch sagt, und darauf dann entsprechend Internetsuchen starten kann oder eine entsprechende App öffnet.

Media Smart e. V.: Was ist eure Meinung zu Smart Toys?

Fabian: Also generell von der Sicht der IT-Security, aus Erfahrung würde ich sagen, ist es so, dass die Sicherheit eines Smart Toys geringer ist als die der Smart Speaker. Weil die Smart Speaker kommen eben von Google und Amazon vor allem, riesige Firmen, die da sehr viel Geld reinstecken auch und sehr viel Interesse daran haben, dass es alles gut wird. Smart Toys kommen eben oft von irgendwelchen Spielehestellern, die wenig Erfahrung mit Technologien haben und das irgendwie outsourcen oder das ihr erstes Projekt ist. Oder diese Smart Toys kommen halt von irgendwelchen günstigeren Herstellern aus Asien. Das heißt, aus der Sicherheitsperspektive würde ich vielleicht ein wenig vorsichtiger rangehen.

Weitere spannende Nachgefragt-Interviews